Śmiertelne ofiary Tesli, o których Musk milczy

W okolicach roku 2015 mogło się wydawać, że autonomiczne samochody to pieśń bardzo niedalekiej przyszłości, że z ulic szybką znikną tradycyjne samochody i zastąpią je robotaksówki. Już za chwilę, już za momencik. Po tamtym entuzjazmie niewiele zostało, a przypadek Tesli pokazuje, że sprawa jest naprawdę skomplikowana.

Pod koniec czerwca 2016 roku Tesla informowała na swoim firmowym

blogu o tragicznej stracie: na Florydzie zginął kierowca korzystający z funkcji Autopilota. Jego Model S z dużą prędkością przejechał pod naczepą ciężarówki, przez co górna część samochodu osobowego została po prostu ścięta. Zapewne wraz z głową i torsem nieszczęśnika siedzącego za kierownicą. O sprawie zrobiło się głośno, bo sama firma utrzymywała wówczas, że był to pierwszy śmiertelny wypadek z udziałem jej Autopilota, czyli funkcji autonomicznej, a przynajmniej częściowo autonomicznej jazdy.

Pod koniec czerwca 2016 roku Tesla informowała na swoim firmowym

blogu o tragicznej stracie: na Florydzie zginął kierowca korzystający z funkcji Autopilota. Jego Model S z dużą prędkością przejechał pod naczepą ciężarówki, przez co górna część samochodu osobowego została po prostu ścięta. Zapewne wraz z głową i torsem nieszczęśnika siedzącego za kierownicą. O sprawie zrobiło się głośno, bo sama firma utrzymywała wówczas, że był to pierwszy śmiertelny wypadek z udziałem jej Autopilota, czyli funkcji autonomicznej, a przynajmniej częściowo autonomicznej jazdy.Harry Potter hulał do końca – jak radyjko w espero

Dla wielu kierowców była to zapewne szokująca informacja, bo funkcja Autopilota, która pojawiła się kilka kwartałów wcześniej, miała nie tylko odciążyć kierowców, ale też poprawić ich bezpieczeństwo: człowiek może się zmęczyć, rozkojarzyć, zasnąć, oślepi go słońce czy światła innego pojazdu. Co innego elektronika, ta jest odporna na ludzkie słabości. W maju 2016 roku, gdy doszło do wypadku, okazało się jednak, że biała naczepa była niewidzialna dla systemów Tesli. Sam kierowca mógł jej nie zauważyć, bo podobno oglądał film – artykuły z tamtego okresu przekonywały, że Harry Potter śmigał na odtwarzaczu płyt nawet po wypadku.https://www.youtube.com/watch?v=5TjbqVartjM&t=1s

Dość szybko media poinformowały, że ofiarą wypadku był człowiek, który za pośrednictwem mediów społecznościowych… promował „jazdę bez trzymanki” i autonomiczne funkcje Tesli. Prezentował nawet materiały pokazujące, jak Autopilot uniknął wcześniej kolizji na autostradzie. Na Twitterze filmem chwalił się Elon Musk. Entuzjazm fana nowych rozwiązań okazał się zbyt duży.

Bycie pierwszą ofiarą śmiertelną Autopilota (niektórzy stwierdzą, że raczej głupoty samego kierowcy) to kiepska nobilitacja, ale nawet z tym tytułem Amerykanin musiał się pożegnać, gdy okazało się, że kilka miesięcy wcześniej, na początku 2016 roku, w mieście Handan w Chinach młody mężczyzna zginął na autostradzie, gdy jego Tesla Model S wjechała w inny pojazd. Funkcja Autopilota była uruchomiona. Jedną z konsekwencji tego zdarzenia było usunięcie przez firmę Muska terminu „Autopilot” z opisu samochodów na chińskiej stronie internetowej producenta.

Zła wiadomość: nie działa. Dobra wiadomość: stworzyli Autopilota

Zdarzenia te można oczywiście tłumaczyć problemami wieku dziecięcego, czyli niedociągnięciami wynikającymi ze świeżości Autopilota. Sęk w tym, że wypadki śmiertelne powiązane z tym rozwiązaniem miały też miejsce po 2016 roku. Do jednego doszło nawet całkiem niedawno, na początku 2023 roku w Kalifornii. Tesla wjechała wówczas w wóz strażacki, a jej kierowca nie przeżył wypadku. Media zwracały uwagę, że na terenie USA minimum 15 aut tego producenta uderzyło w pojazdy uprzywilejowane podczas korzystania z funkcji Autopilota.

Do tematu warto wrócić za sprawą artykułu opublikowanego przez The Washington Post. Jego autor powołuje się na dane amerykańskiego urzędu ds. bezpieczeństwa ruchu drogowego (National Highway Traffic Safety Administration, NHTSA), z których wynika, że od 2019 roku tylko w USA doszło do ponad 730 wypadków z udziałem samochodów Tesli działających w trybie Autopilota. Kilkanaście z nich to wypadki śmiertelne – w ciągu ostatniego roku zdarzenia tego typu miały spowodować śmierć 11 osób.

Jeszcze ciekawiej robi się, gdy sięgnie się po dane prezentowane na stronie tesladeaths.com. Wynika z niej, że do 20 czerwca br. w wypadkach z udziałem Tesli zginęło niemal 400 osób. Przy czym trzeba zaznaczyć, że liczba ta obejmuje nie tylko kierowców i pasażerów samochodów tej marki, ale też innych uczestników ruchu drogowego – np. motocyklistów, którzy zderzyli się z samochodami produkowanymi przez firmę Elona Muska. Wedle tych wyliczeń zgonów, które nastąpiły podczas używania Autopilota było 35.

Statystyka vs. rzeczywistość

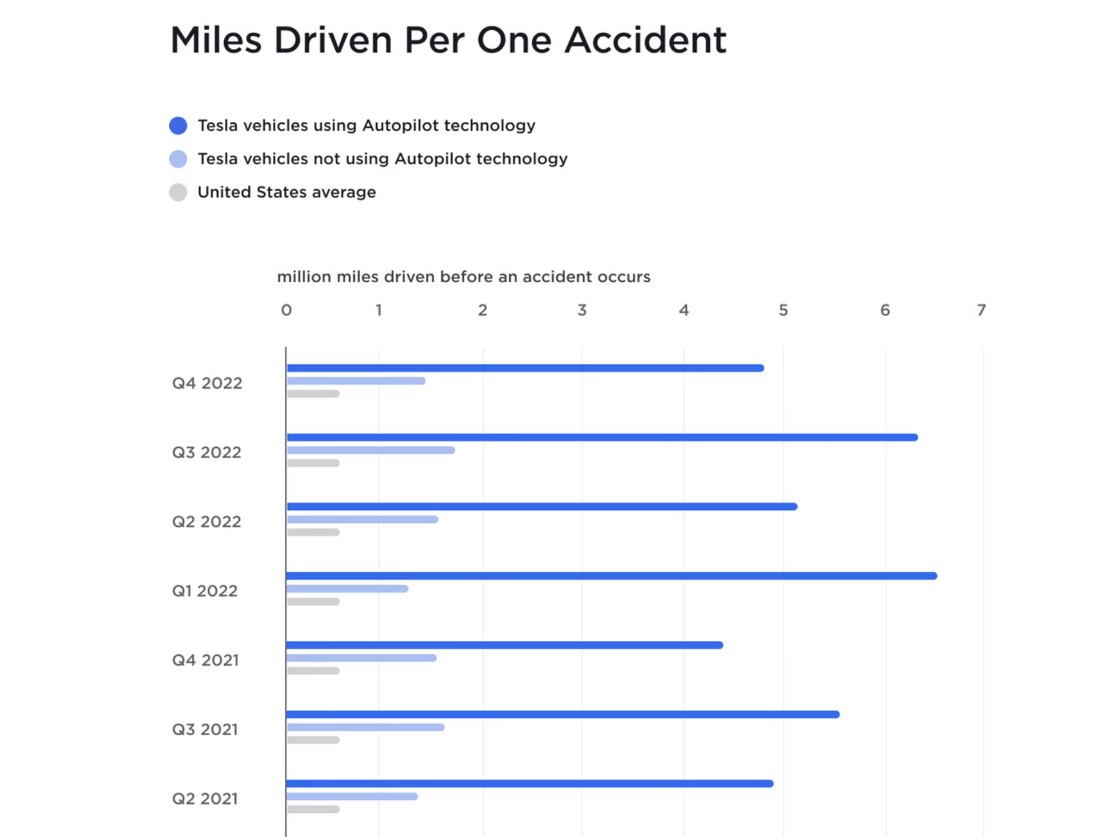

Odnosząc się do tych kwestii, przedstawiciele firmy zazwyczaj przekonują, że samochód autonomiczny czy wspierany przez asystenta jazdy (autopilota) i tak jest bezpieczniejszy niż pojazd kierowany wyłącznie przez człowieka. Ten wątek pojawił się m.in. w komentarzu do pierwszego potwierdzonego wypadku śmiertelnego. Tesla podała wówczas, że nim doszło do tragedii, jej samochody w trybie Autopilota przejechały 130 mln mil. Tymczasem średnio w USA ofiara śmiertelna przypada na 94 mln przejechanych mil.Producent samochodów elektrycznych co kwartał prezentuje też dane pokazujące, co ile przejechanych mil zdarza się wypadek. W okresie październik-grudzień 2022 roku średnia dla USA wyniosła 652 tys. mil. Tymczasem dla Tesli z wyłączonym Autopilotem było to 1,4 mln mil, a dla Tesli z aktywnym Autopilotem aż 4,85 mln mil. A to i tak kiepski rezultat, bo kwartał wcześniej do wypadku Tesli z włączonym Autopilotem dochodziło co 6,26 mln przejechanych mil.

Sceptycznie do tych statystyk podszedł autor artykułu opublikowanego przez The New York Times, który podkreślił, że Autopilot jest używany przede wszystkim na autostradach, po których poruszanie się jest bardziej bezpieczne niż jazda po lokalnych drogach czy ulicach miasta. Jego zdaniem Autopilot wypada lepiej, bo jest po prostu stosowany w bardziej przyjaznym środowisku. Do bardziej miarodajnych badań potrzebne byłyby większe ilości danych od producenta samochodów, ale ten niekoniecznie chce się nimi dzielić. I nie jest to zachowanie właściwe tylko dla Tesli – jej konkurencja też nie publikuje masowo statystyk, zasłaniając się tajemnicą handlową.

To nie był Elon. To deepfake

Niektórzy odbiorcy mogą nie wierzyć dziennikarzom, urzędnikom czy bezimiennym przedstawicielom firm, ale zaufają Elonowi Muskowi. A miliarder wielokrotnie przekonywał, że pojazdy autonomiczne to przyszłość (bardzo bliska), że nie należy się ich obawiać, wreszcie że samochody poruszające się w trybie Autopilota są bardziej bezpiecznie niż te kierowane wyłącznie przez człowieka. Liczne media cytowały te wypowiedzi, w sieci nie brakuje filmów, w których takie słowa padają z ust popularnego biznesmena. Ale czy rzeczywiście je wypowiedział?https://youtu.be/wsixsRI-Sz4?t=4766

Pytanie może się wydawać śmieszne lub nawet głupie, ale nie dla prawników reprezentujących Muska. Kilka miesięcy temu przekonywali oni sąd, że ich klient nie może sobie przypomnieć, czy rzeczywiście zadeklarował, iż samochody Tesli mogą jeździć bezpieczniej, gdy steruje nimi maszyna, a nie człowiek. Prawnicy amerykańskiego producenta aut zapewniali jednocześnie sąd, że ich szef często pada ofiarą tzw. deepfake’ów, czyli filmów lub obrazów, w których np. rozprzestrzenia się fałszywe informacje. Innymi słowy: za całym tym chwaleniem się Autopilotem nie musi stać Musk, ale np. rosyjscy, chińscy czy północnokoreańscy hakerzy, którzy chcą zaszkodzić perle w koronie amerykańskiej gospodarki.

https://youtu.be/wsixsRI-Sz4?t=4763

Skąd taka narracja? Ano stąd, że sprawa dotyczy jednego z wypadków śmiertelnych z udziałem Autopilota. W 2018 roku śmierć poniósł inżynier Apple, a jego rodzina domaga się sprawiedliwości (i zapewne wysokiego odszkodowania), przekonując, że zawiodło oprogramowanie samochodu. Software tak bardzo zachwalany przez Muska. Łatwo sobie wyobrazić, że wyrok korzystny dla rodziny ofiary mógłby się okazać sporym problemem dla Tesli. Już lepiej iść w zaparte i przekonywać, że Musk z filmu nie jest prawdziwy. Cytując klasyka: jak cię złapią za rękę, mów, że to nie twoja ręka.

Wkurzone rodziny ofiar, niezadowoleni akcjonariusze...

Pracownicy działu prawnego Tesli zapewne odetchnęli z ulgą, gdy wiosną zapadł korzystny dla firmy wyrok w sprawie toczącej się przed kalifornijskim sądem. Korporację pozwała kobieta, która uległa wypadkowi w 2019 roku. Jej samochód w trybie Autopilota zjechał na krawężnik, co uruchomiło poduszkę powietrzną, a ta miała doprowadzić m.in. do wybicia zębów i złamania szczęki kobiety kierującej autem. Jej prawnicy przekonywali, że mieszkanka Los Angeles została wprowadzona w błąd co do możliwości systemów jazdy autonomicznej. Przedstawiciele Tesli bronili się, przekonując, że system ten nie powinien być stosowany w mieście, o czym informuje instrukcja obsługi. Z ich argumentacją zgodzili się członkowie ławy przysięgłych. Może się okazać, że ten wyrok stanie się orężem Tesli w podobnych sprawach i uchroni ją przed gigantycznymi odszkodowaniami.-20230712210528.jpg)

Problemem dla Tesli są rodziny ofiar czy osoby poszkodowane w wypadkach, ale też akcjonariusze firmy. Na początku br. pojawiła się informacja, iż złożyli oni pozew zbiorowy, ponieważ uznali, że byli oszukiwani przez producenta aut w kwestii możliwości Autopilota. Sprawa kręci się wokół finansów, a konkretnie ceny akcji Tesli – ta miała spaść, zdaniem pozywających, właśnie za sprawą kłopotów, jakie wywołuje niedopracowany i wciąż rozwijany Autopilot.

Do wyraźnego osłabienia kursu akcji doszło m.in. w połowie lutego br. Urzędnicy przywołanego już National Highway Traffic Safety Administration zarekomendowali wówczas Tesli przeprowadzenie aktualizacji oprogramowania w samochodach w celu usunięcia usterek. Chodziło m.in. o to, że pojazdy poruszające się w trybie Full Self-Driving (FSD) czasem nie przestrzegają ograniczeń prędkości i niewłaściwie zachowują się na skrzyżowaniach. Sam Musk zastanawiał się wtedy na Twitterze, czy można mówić o wzywaniu pojazdów do naprawy (jak ujęli to urzędnicy), jeśli cały proces odbywa się zdalnie. W odpowiedzi niektórzy użytkownicy social mediów pytali go, czy uczciwie jest informować o w pełni autonomicznej jeździe, gdy w rzeczywistości samochody nie oferują takiej funkcji.

Wcześniej producent zmagał się m.in. z problemem tzw. hamowania fantomowego. Zjawisko polega na tym, że systemy wykrywają zagrożenie w sytuacjach, w których w rzeczywistości ono nie występuje. Autopilot może wówczas zareagować gwałtownym hamowaniem, które jest niebezpieczne nawet na pustej drodze. Tymczasem do takiego hamowania dochodziło na ruchliwych drogach – przecież teslowy asystent ma być stosowany np. na autostradach. Łatwo sobie wyobrazić, że w takiej sytuacji w tył hamującego samochodu wjeżdżają inni uczestnicy ruchu drogowego. Sprawiedliwie będzie jednak napisać, że z hamowaniem fantomowym zmagają się też inni producenci samochodów.

Produkt niby gotowy, ale eksperyment trwa

Szerokim echem odbiła się w branży decyzja Tesli z 2021 roku, by Autopilot korzystał z rozwiązania Tesla Vision wykorzystującego wyłącznie kamery i oprogramowanie. Wcześniej asystent jazdy polegał też na pracy np. radaru. Niedobory i jakość, w domyśle wątpliwa, tego ostatniego sprawiły, że postanowiono odchudzić pojazdy o niektóre komponenty. Firma zapewniała na swojej stronie internetowej:Od czasu premiery nieustannie wprowadzamy stopniowe ulepszenia zarówno w zakresie równoważności funkcji, jak i bezpieczeństwa. W porównaniu z pojazdami wyposażonymi w radary Model 3 i Model Y z systemem Tesla Vision utrzymały lub poprawiły swoje wskaźniki bezpieczeństwa czynnego w USA i Europie oraz osiągają lepsze wyniki w przypadku interwencji automatycznego hamowania awaryjnego (AEB).

Część komentatorów nie zgadzała się jednak z tą narracją i pytała głośno, czy wypadki z udziałem samochodów Tesli nie wynikają m.in. z usunięcia radarów. Ponoć przeciwna takiemu posunięciu była nawet część inżynierów amerykańskiej firmy. Stara prawda ludowa głosi jednak, że tylko krowa nie zmienia zdania – kilka miesięcy temu pojawiły się doniesienia, że Tesla będzie używać radaru.

Sprawę wypadków trudno bagatelizować, bo samochodów Tesli, ale też innych firm, które eksperymentują z rozwiniętymi asystentami jazdy, na ulicach przybywa. A pojazd z funkcją jazdy autonomicznej, która nie spełnia swojej roli, zagraża nie tylko siedzącym w nim ludziom, lecz także innym kierowcom, motocyklistom czy pieszym. Na sprawę warto jednak spojrzeć również z innej strony. Bo chociaż Tesla niejednokrotnie chwaliła się, że dowiozła temat jazdy autonomicznej, to na stronie producenta można przeczytać, że

Dostępne obecnie funkcje Autopilota wymagają aktywnego nadzoru kierowcy i nie zapewniają autonomicznego kierowania pojazdem.

Albo

Podczas korzystania z Autopilota obowiązkiem kierowcy jest zachować czujność, przez cały czas trzymać ręce na kierownicy i zachować kontrolę nad samochodem.

Kierowca wie swoje. Czyli lepiej

Tymczasem posiadacze tych samochodów podchodzą do tematu… różnie. Pod koniec ubiegłego roku niemiecka policja próbowała zatrzymać na autostradzie Teslę, której kierowca spał. Przez kilkanaście minut radiowóz podążał za samochodem jadącym z prędkością 110 km/h, a policjanci mieli nadzieję, że facet w końcu się obudzi. Gdy tak się stało, wyszło na jaw, że mężczyzna oszukał system obciążnikiem przymocowanym do kierownicy.https://www.youtube.com/watch?v=TYZrehVQouc

Kilka lat temu głośno zrobiło się o kierowcy, który za pośrednictwem YouTube'a chwalił się zhackowaniem systemów bezpieczeństwa Tesli. Te domagają się, by ręce kierowcy wywierały nacisk na kierownicę, ale pomysłowy Amerykanin posłużył się w tym celu pomarańczą. W podobnym celu używano też plastikowej butelki czy piłeczki. Żeby grono inżynierów Tesli nie pomyślało, że jest takie sprytne – klienci udowadniają, że potrafią ich przechytrzyć. Nawet ze szkodą dla siebie...

Oglądany:

34614x

|

Komentarzy:

98

|

Okejek:

95

osób

Najpotworniejsze ostatnio

Najnowsze artykuły

28.04

- Wysyp memów o Suskim, który był podsłuchiwany Pegasusem (21)

- Typowa rewitalizacja na polskim rynku – Demotywatory (356)

- Najdziwniejsze rzeczy, jakie sprzedawcy musieli tłumaczyć swoim klientom (98)

- Mam dość pracy z Polką, nie chcę drugiego dziecka i inne anonimowe opowieści (95)

- Jak kiedyś wyobrażano sobie przyszłość? Czyli futurystyczne rzeczy z dawnych lat (48)

- Jak one szybko dorastają (4)

- Seksowne selfiki (41)

- Tajemnice, jakie skrywają kostiumy filmowe (40)

- Chodzili do szkoły z celebrytami lub ich uczyli - teraz dzielą się swoimi historiami, które pokazują, jacy oni byli (31)

- Bo trzeba mieć pomysł, czyli kreatywne podejście do otaczającego świata (5)

- Dzień z życia kierowcy autobusu - jak to wygląda naprawdę? (85)

27.04

- Mistrzowie Internetu – Jak wygląda kuchnia Marianny Schreiber (96)

- Tego już nie zobaczycie w grze Tomb Raider III. Twórcy remastera wprowadzili cenzurę – W co jest grane? (32)

- Ty naprawdę tak żyjesz? – Pozytywne i negatywne zaskoczenia odkryte w czyichś domach (36)

- Wielopak Weekendowy – Mam wiele ukrytych talentów...

- Dziwne i jeszcze dziwniejsze samochody (34)

- Urocze dziewczyny i ich słodkie psiaki (23)

- Turyści, którzy doznali szoku kulturowego, odwiedzając inne kraje, dzielą się swoimi historiami II (60)

- Nierozwiązane zagadki - zaginięcie latarników na Wyspach Flannana (34)

- 15 zabawek, które nie powinny znaleźć się w sprzedaży, a mimo to tam trafiły (80)

Sprawdź swoją wiedzę!

Jak to drzewiej bywało

Dobra, dobra. Chwila. Chcesz sobie skomentować lub ocenić komentujących?

Zaloguj się lub zarejestruj jako nieustraszony bojownik walczący z powagą